Pierwsza rzecz jest już dość stara, ale do dziś nie znalazłem lepszego wprowadzenia dla laików w techniczne aspekty „AI”, które konsumują publiczną uwagę dzisiaj: wielkie modele językowe (LLM).

Polecam „What Is ChatGPT Doing … and Why Does It Work?” Stephena Wolframa nawet jeśli, w mojej opinii, trochę za bardzo forsuje pogląd, że LLM-y w istotny sposób modelują ludzkie myślenie, a same model są zbudowane na idealizacji ludzkiego mózgu. Wolfram ma na myśli sieci neuronowe, idealizację naszego wyobrażenia o tym, jak działają układy nerwowe:

Podstawowa koncepcja działania ChatGPT jest na pewnym poziomie dość prosta. Zaczyna się od ogromnej próbki tekstów stworzonych przez ludzi — z internetu, książek itd. Następnie trenuje się sieć neuronową, aby generowała tekst, który jest „podobny do tego”. W szczególności robi się to tak, aby była w stanie zacząć od „promptu” (czyli podanej frazy początkowej), a następnie kontynuować tekstem „podobnym do tego, na czym była trenowana”.

Jak widzieliśmy, faktyczna sieć neuronowa w ChatGPT składa się z bardzo prostych elementów — choć są ich miliardy. A podstawowe działanie tej sieci również jest bardzo proste: zasadniczo polega na jednokrotnym przepuszczeniu wejścia — pochodzącego od tekstu wygenerowanego do tej pory — „przez jej elementy” (bez żadnych pętli itp.) dla każdego nowego słowa (lub fragmentu słowa), które generuje.

Ale niezwykłe — i nieoczekiwane — jest to, że proces ten potrafi wytworzyć tekst, który z powodzeniem jest „podobny” do tego, co znajduje się w internecie, w książkach itd. I nie tylko jest to spójny język ludzki, ale także „mówi rzeczy”, które „podążają za promptem”, wykorzystując treści, które „przeczytał”. Nie zawsze mówi rzeczy, które „globalnie mają sens” (lub odpowiadają poprawnym obliczeniom) — ponieważ (…) po prostu mówi rzeczy, które „brzmią właściwie” na podstawie, jak rzeczy „brzmiały” w materiale treningowym.

On, jak i inni zwolennicy „sieci neuronowe to model mózgu” pomijają fakt, że faktycznie sieci neuronowe to matematyczna idealizacja tego, jak działają neurony. Z tym że wedle wiedzy o fizjologii układu nerwowego sprzed jakichś 70 lat.

Wolfram to brytyjski fizyk, matematyk i przedsiębiorca, twórca programu Mathematica. Jako autor zdecydowanie nie boi się posiadać opinii, niekoniecznie podzielanych przez całość mainstreamu, natomiast wydaje mi się, że poza może odrobinę nadmiernym reklamowaniem własnego oprogramowania jako „dopełnienia czatu GPT” w późniejszej części swojego wprowadzenia, jako całość jest ono dobrym i neutralnym punktem startowym dla kogoś, kto nie mając uprzedniej wiedzy, chce uzyskać rozumienie jak działają LLM-y. Druga połowa jego długiego artykułu (wydanego nawet jako mała książeczka) jest już dość techniczna, ale wydaje mi się, że przynajmniej pierwsza połowa powinna być zrozumiała dla uważnego laika pozbawionego uprzedniego przygotowania matematycznego (może poza poziomem szkoły podstawowej).

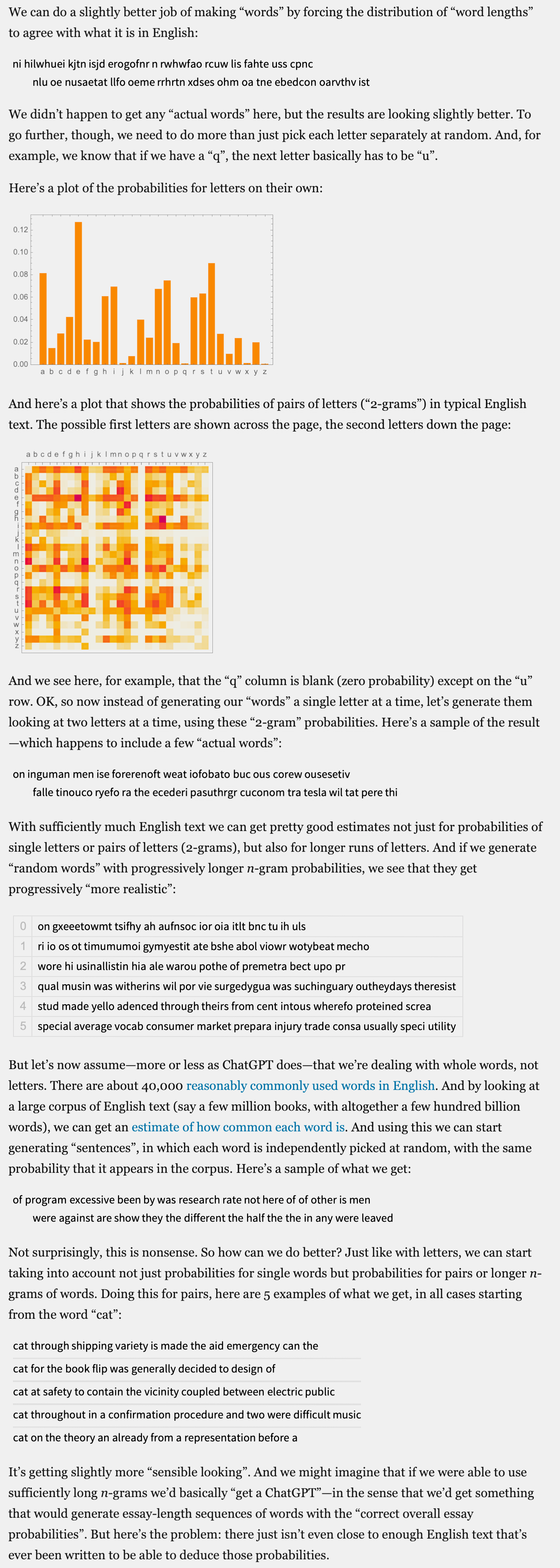

Wolfram zaczyna od bardzo podstawowych kwestii na temat tego, jak można statystycznie modelować języki. Tu jeden z moich ulubionych fragmentów, w którym fajnie ilustruje to, jak minimalne zwiększeni komplikacji modelu statystycznego prowadzi do uzyskania znacząco lepszej jakości „symulacji” języka:

Następnie przechodzi do kwestii tego, jak działają sieci neuronowe i matematyczne modele różnych zjawisk w ogóle, dalej wyjaśnia kwestie bardziej techniczne, takie jak „embeddingi” czy rolę tokenów, wreszcie przechodzi do objaśnienia unikalnej architektury transformerów i pojęcia „uwagi”, czyli modyfikacji standardowej struktury sieci neuronowych, które były kluczowe dla stworzenia funkcjonujących LLM-ów.

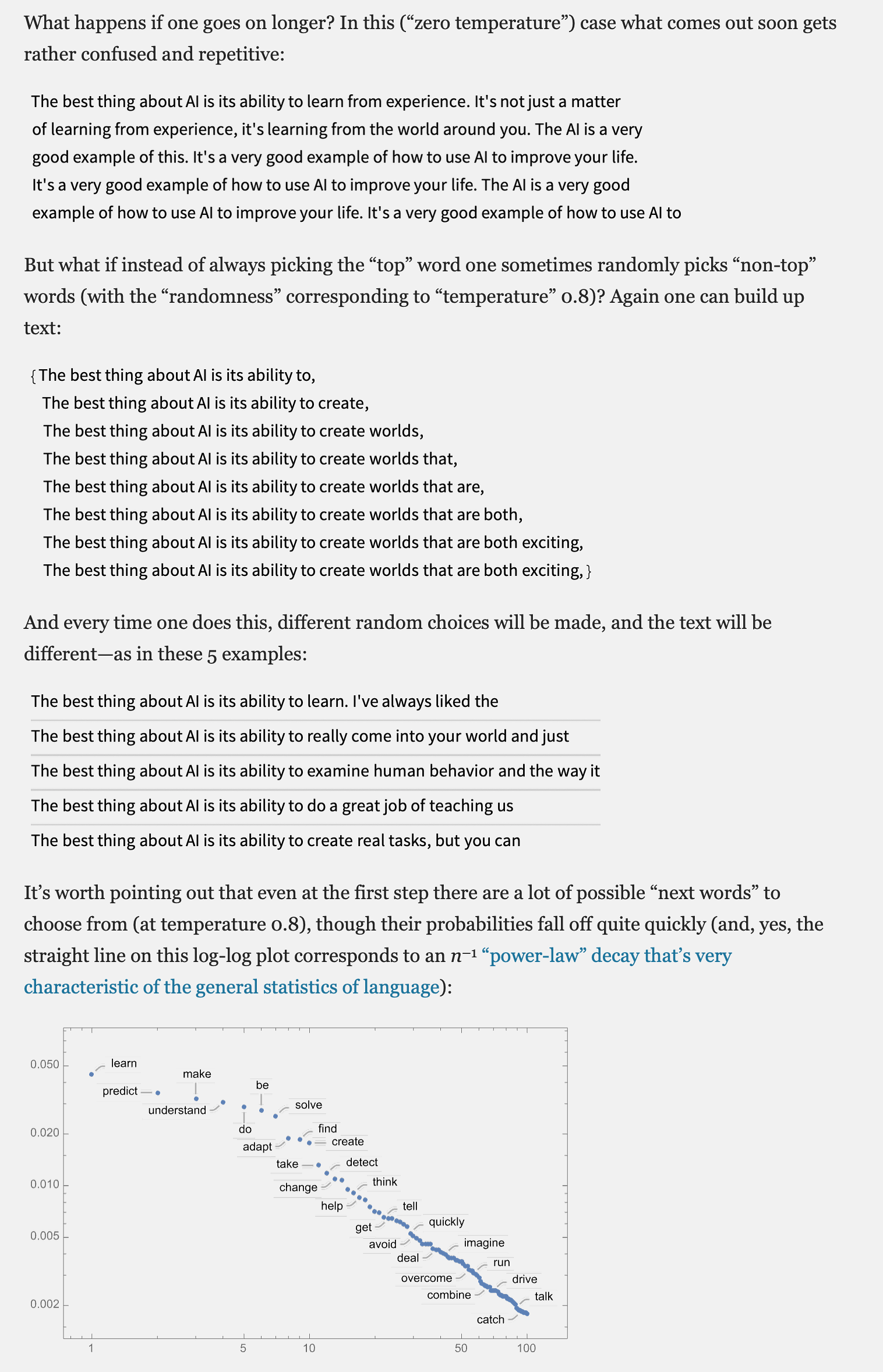

Jego wprowadzenie zawiera też bardzo fajne omówienie pojęcia „temperatury” w tych modelach, pozwalające zrozumieć, że statystyczne przewidywanie „najbardziej prawdopodobnej kontynuacji” dla zadanego tekstu nie prowadzi do uzyskania wyniku, który wygląda jak przekonujący fragment ludzkiego języka:

Tak jak wspominałem, to ciekawy, choć długi tekst, ale może to być bardzo dobrze spędzone popołudnie, biorąc od uwagę, jak bardzo powszechną uwagę konsumują mniej lub bardziej dorzeczne narracje o LLM-ach i ich zdolnościach.

Drugi tekst jest o potencjalnych skutkach proliferacji LLM-ów i generatywnej AI w kontekście społecznym. Cory Doctorow, autor popularnego w ostatnich latach pojęcia gównowacenia, które służy opisowi dość uniwersalnego modelu tworzenia usług w późnym kapitalizmie, spodziewa się gigantycznego krachu gospodarczego wywołanego absurdalnymi oczekiwaniami irracjonalnych rynków: „The real (economic) AI apocalypse is nigh”:

To nie jest jak wczesne lata internetu, czy Amazona, albo innych wielkich zwycięzców, którzy tracili pieniądze zanim stali się rentowni. Tamte przedsięwzięcia miały świetne „unit economics” — wraz z każdą kolejną generacją technologii stawały się tańsze, a im więcej zdobywały klientów, tym bardziej były dochodowe. Firmy zajmujące się AI mają — używając trafnego określenia Eda Zitrona — „gówniane unit economics”. Każda generacja AI była ogromnie droższa od poprzedniej, a każdy nowy klient AI sprawia, że te firmy tracą jeszcze więcej pieniędzy.

Jako literat nasyca swój tekst, pełen interesujących linków do innych, ładnymi metaforami, szczególnie podoba mi się ta z azbestem:

Wreszcie: AI nie potrafi wykonać twojej pracy, ale sprzedawca AI w 100% przekona twojego szefa, by cię zwolnił i zastąpił AI, która tej pracy nie potrafi wykonać, a kiedy bańka pęknie, „modele bazowe” tracące miliardy zostaną wyłączone i stracimy tę AI, która nie potrafiła wykonać twojej pracy – a ciebie już dawno nie będzie, przekwalifikowanego, na emeryturze albo „zniechęconego” i poza rynkiem pracy, i nikt nie będzie wykonywał twojej pracy. AI jest jak azbest, którym zapychamy ściany naszego społeczeństwa, a nasi potomkowie będą go usuwać przez pokolenia.

To właśnie przez artykuł Doctorowa trafiłem na absolutnie fascynujący tekst, który będzie moją ostatnią polecajką dzisiaj: „AI as Normal Technology”:

Przedstawiamy wizję sztucznej inteligencji (AI) jako zwyczajnej technologii. Postrzeganie AI jako czegoś normalnego nie oznacza umniejszania jej wpływu — nawet technologie o charakterze przełomowym i ogólnego zastosowania, takie jak elektryczność czy internet, również uznajemy w tym ujęciu za „normalne”. Chodzi natomiast o przeciwstawienie się zarówno utopijnym, jak i dystopijnym wizjom przyszłości AI, które mają wspólną tendencję do traktowania jej jak oddzielnego gatunku — wysoko autonomicznej, potencjalnie superinteligentnej istoty.

Stwierdzenie „AI to zwyczajna technologia” ma trojaki charakter: jest opisem obecnego stanu AI, prognozą dotyczącą jej przewidywalnej przyszłości oraz wskazówką, jak powinniśmy ją traktować. Postrzegamy AI jako narzędzie, nad którym możemy i powinniśmy zachować kontrolę — i twierdzimy, że osiągnięcie tego celu nie wymaga ani drastycznych interwencji politycznych, ani przełomów technicznych. Uważamy, że traktowanie AI jako inteligencji podobnej do ludzkiej nie jest obecnie trafne ani użyteczne dla zrozumienia jej wpływu społecznego — i w naszej wizji przyszłości raczej takie nie będzie.

Nie wiem, dlaczego przegapiłem go wcześniej, ale wydaje mi się rzadkim przykładem wywodu, który nie umniejszając potencjału generatywnych AI, rozsądnie kontruje apokaliptyczną i fantastyczną narrację o „AI” jako bogotronie in statu nascendi, który wkrótce wynicuje ludzką cywilizację.

Miłego czytania!